ローカルで高品質の動画を生成できる驚きのアプリケーションがアリババからリリースされました。

この驚きの動画生成AI「wan2.1」をローカルで使いたい方へ、Wan2.1の機能や環境構築方法、ワークフローの工夫からRTX5000シリーズで起きやすいエラーと解決方法までをわかりやすく解説します。

- Wan2.1はなにがすごいのか?

- 環境構築方法やセットアップ手順

- RTX5000シリーズで起きるエラーと解決策

- ComfyUIを使ったワークフロー構築の方法

- LoRA対応による拡張と活用の仕方

- 利用料金やライセンスに関する注意点

- DiscordやGoogle Colabで使用する方法

wan2.1 をローカルで使う方法と環境構築手順

Wan2.1の機能とは?

Wan2.1は高性能な生成系モデルで、ローカル環境でも高品質な動画を生成できるアプリです。具体的には次のような機能があります。

- 高解像度の画像生成

- テキストからの自然な変換

- LoRAや外部プラグインとの連携

動画生成に当たり速度重視、品質重視など様々なモデルがあります。

実際にWan2.1で生成した動画

この動画は日本語でプロンプトを書いて生成した動画です。

プロンプトは日本語で「リアルテイスト、パティシエの服装の猫がホールケーキを作っている。アメリカ家庭のキッチン」と短めで720pで生成しました。5秒の生成でも20分ほどかかりました。

Wan2.1はなにがすごい?

Wan2.1が注目される理由は以下の点です。

- ローカル動作でクラウド依存がない

- 高速な処理能力でリアルタイム利用が可能

- ユーザー自身の環境に合わせた柔軟なカスタマイズ

特に、オフラインでも利用できる点が多くのユーザーにとって魅力ですが、なんといってもSoraなどと違い、Loraなどで自分でカスタマイズ・コントロールして動画を少ないGPUで生成できる環境を構築できることです。

動作環境を満たすための要件

wan2.1を快適に利用するためには、推奨される動作環境を確認する必要があります。

| 項目 | 推奨環境 |

|---|---|

| GPU | RTX3000シリーズ以上 |

| VRAM | 6GBから生成可能 高画質は12GB以上推奨 |

| OS | Windows10以降、Linux最新環境 |

| RAM | 32GB以上推奨 |

上記を満たしていない場合、動作が不安定になる可能性があります。

wan2.1をローカル環境でのセットアップする手順

セットアップの流れは次の通りです。

- Pythonと依存ライブラリのインストール

- Wan2.1モデルのダウンロード

- 環境変数の設定

- 実行確認と動作テスト

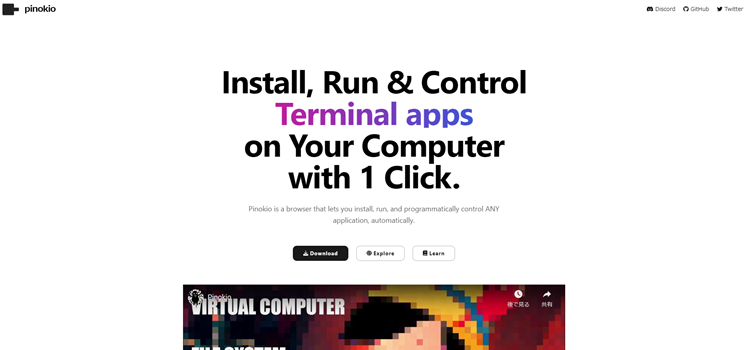

この流れを踏むことでスムーズに利用を始められます。私はPinokio.coという多くのAIアプリを統合管理できるアプリでインストールしました。

Pinokio.coでインストールするメリットはクリックするだけで環境を構築できることで、コマンド入力が苦手な人でも簡単にAIソフトをインストールすることができます。

Pinokio.coに関してはこちら

Pinokio.coでWan2.1をインストールする手順

自分のPCにインストールした時の環境

| CPU | AMD Ryzen 7 7700 |

| GPU | RTX 5070ti |

| メモリ | 32GB |

| ストレージ | 1TB |

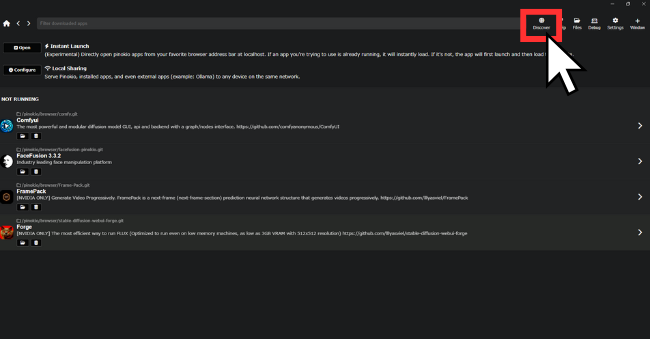

ホームの画面右上の地球マークをクリックしてAIアプリ一覧を探せるページに移動する

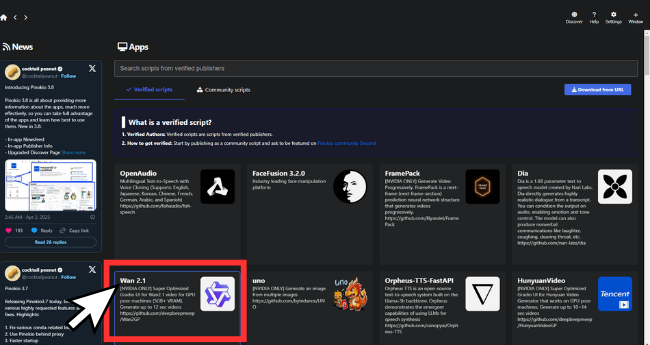

選択するとインストールボタンがあるのでクリックしてインストールをする。インストール画面がでるので終わるまで待つ

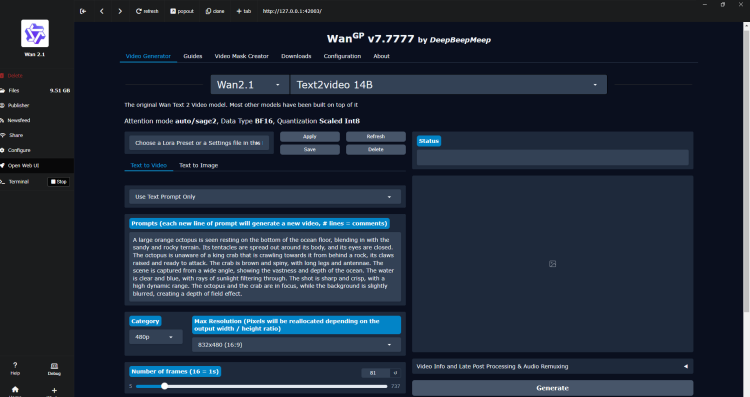

インストールが終わったらスタートボタンをクリックしUIが立ち上がることを確認する

Wan2.1のRTX5000シリーズでおきるエラーと解決方法

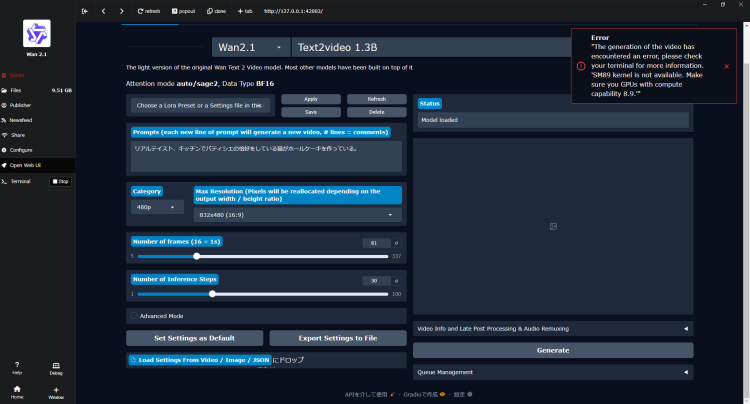

RTX5000シリーズ特有のエラーが報告されているようで私も5070tiを使用しているため下の画像のようなエラー文が出て動画の生成に失敗しました。

エラー文の内容

"The generation of the video has encountered an error, please check your terminal for more information. 'SM89 kernel is not available. Make sure you have GPUs with compute capability 8.9.'"エラー文を直訳すると

「動画の生成中にエラーが発生しました。詳細については端末を確認してください。『SM89 カーネルが利用できません。計算能力 8.9 を持つ GPU が搭載されていることを確認してください。』」どういうことかというとRTX5000シリーズ(Blackwell)に合わせたカーネル(オペレーティングシステム (OS) の中心的な部分)が不足しているため動かないという状態でした。

私の使用している5070 Ti は Blackwell 世代のためエラーが発生に直面しました。

NVIDIA公式の CC(Compute Capability)一覧では GeForce RTX 5070 Ti は CC 12.0 に分類されています。つまり、デフォルトでインストールされた状態ではSM89(8.9)専用でビルドされた SageAttentionなのでCC 12.0のSageAttention を入れ直す必要がでました。

私はアプリケーション開発の専門家ではないので、下記のURLを参考にChatGPTに投げかけながらSageAttentionのフォルダを削除してインストールしなおしました。

参考元:https://github.com/deepbeepmeep/Wan2GP/issues/746

これでWan2.1で無事動画を生成することができました。

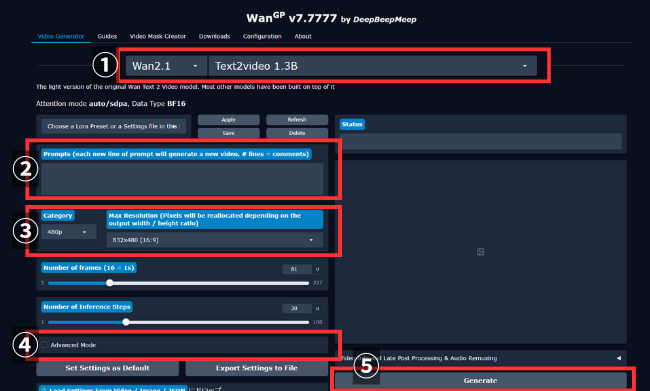

Wan2.1の基本的な使い方

Wan2.1の基本的な使い方は次の3ステップになります

- モデルを選ぶ

- プロンプトを入力する

- 生成ボタンを押す

Stable diffusionを触ったことがある方ならネガティブプロンプトからSEED値などイメージしやすい項目もあるので操作に苦労することは少なそうです。

基本的には画像生成と同じで、はじめはスピード重視のモデルで数多く生成してよさそうなSEED値をみつけたらそれを高画質モデルで生成しなおすといった流れになるかと思います。

ただ、画像生成と違って動画生成は時間がかかるのがネックになります。

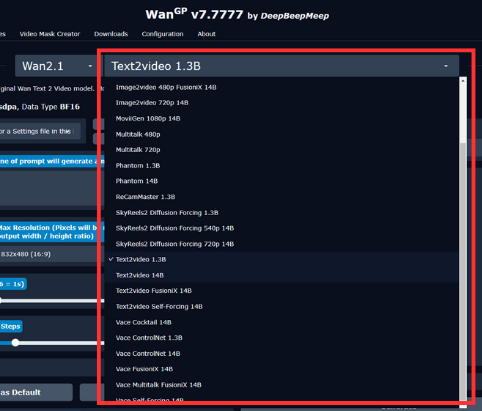

モデルの特徴と早見表

Wanには多くのモデルがあり、それぞれ特徴があります。まずはモデル別の特徴を確認して自身のPCスペックと用途にあったモデルを選ぶようにします。

用途別早見表

| 用途 | 推奨モデル | 補足 |

|---|---|---|

| 生成速度重視 | LTX Video 13B Distilled Wan 2.1 T2V 1.3B CausVid Lora | 高速・生成テスト向き |

| 最高品質 | Hunyuan Video Wan 2.1 T2V 14B Wan Vace 14B | 本番動画向け |

| 高度制御 | Wan Vace 1.3B / 14B Phantom FantasySpeaking | モーショントランスファー、音声同期 |

| 長尺動画 | LTX Video 13B Sky Reels v2 Wan Vace+Sliding Windows | 長編・連続生成 |

| 低スペック環境 | Wan Fun InP 1.3B Wan 2.1 T2V 1.3B Wan Vace 1.3B | VRAM 6GB でも可 |

グラボのVRAM量別に適したモデル

| VRAM | 推奨モデル | 特徴 |

|---|---|---|

| 6–8GB | Wan 2.1 T2V 1.3B Wan Fun InP 1.3B Wan Vace 1.3B | 軽量、試作用、低スペック対応 |

| 10–12GB | Wan 2.1 T2V 14B Wan Fun InP 14B Hunyuan Video(最適化) LTX Video 13B | 高品質生成が可能 |

| 16GB+ | 全モデル利用可 | 長尺、複数 Lora 同時利用 |

| 20GB+ | MoviiGen(実験的) | 1080p、最長・最高品質 |

初心者向け

- はじめて使う場合 → Wan 2.1 T2V 1.3B(軽くて速い)

- 本番品質を求める場合 → Hunyuan Video or Wan 14B

- とにかく速く試したい場合 → LTX Video 13B Distilled or CausVid Lora

- 特殊用途 → VACE(制御)、FantasySpeaking(リップシンク)、LTX(長尺)

性能比較(概要)

- 速度: CausVid Lora > LTX Distilled > Wan 1.3B > Wan 14B > Hunyuan > MoviiGen

- 品質: Hunyuan > Wan 14B > LTX > Wan 1.3B > CausVid

- VRAM効率: Wan 1.3B > LTX(最適化版) > Wan 14B > Hunyuan > MoviiGen

各モデルの特徴と詳細説明

- Wan 2.1 Text2Video 1.3B

-

- パラメータ数: 13億

- VRAM: 最低 6GB

- 速度: 高速生成

- 品質: サイズに対して良好

- 最適用途: クイック反復、低スペック環境

- コマンド:

python wgp.py --t2v-1-3B

- Wan 2.1 Text2Video 14B

-

- パラメータ数: 140億

- VRAM: 推奨 12GB 以上

- 速度: 遅いが高品質

- 品質: 優れたディテールと一貫性

- 最適用途: 最終的なプロダクション動画

- コマンド:

python wgp.py --t2v-14B

- Wan Vace 1.3B

-

- 種類: 高度な動画制御用 ControlNet

- VRAM: 最低 6GB

- 特徴: モーショントランスファー、オブジェクト注入、インペインティング

- 用途: 高度な動画操作

- コマンド:

python wgp.py --vace-1.3B

- Wan Vace 14B

-

- 種類: 大規模 ControlNet モデル

- VRAM: 推奨 12GB 以上

- 特徴: 全 Vace 機能を高品質で利用可能

- 用途: プロ向け動画編集ワークフロー

- MoviiGen(実験的)

-

- 解像度: 1080p を目標

- VRAM: 必要 20GB 以上

- 速度: 非常に遅い生成

- 特徴: シネマ品質の動画生成(2.1 / 1 比率に特化)

- ステータス: 実験的、フィードバック歓迎

- Wan 2.1 Image2Video 14B

-

- パラメータ数: 140億

- VRAM: 推奨 12GB 以上

- 速度: 遅いが高品質

- 品質: 優れたディテールと一貫性

- 最適用途: Lora の多くが対応

- コマンド:

python wgp.py --i2v-14B

- FLF2V

-

- 種類: 始点/終点フレーム特化

- 解像度: 720p 最適化

- サポート: Wan チーム公式

- 用途: 特定の始点・終点を持つ画像から動画化

- Wan 2.1 特殊モデル

-

- Multitalk: 2人までのリップシンク/音声駆動アニメーション

- FantasySpeaking: 人や物体のリップシンクアニメーション

- Phantom: 人や物体の転写(720p、30ステップ以上推奨)

- Recam Master: 別視点生成(81フレーム以上必要)

- Sky Reels v2 Diffusion: 「無限長」動画生成に特化

- Wan Fun InP 1.3B

-

- パラメータ数: 13億

- VRAM: 最低 6GB

- 品質: サイズに対して良好

- 用途: エントリーレベルの画像アニメーション

- コマンド:

python wgp.py --i2v-1-3B

- Wan Fun InP 14B

-

- パラメータ数: 140億

- VRAM: 推奨 12GB 以上

- 品質: より優れた最終画像サポート

- 制限: 既存の Lora との相性が良くない

- Hunyuan Video モデル

-

- Hunyuan Video Text2Video: オープンソース T2V モデル最高クラスの品質、最大 10 秒生成

- Hunyuan Video Custom: 特定人物の注入に特化、キャラクターの一貫性に優れる

- Hunyuan Video Avatar: 最大 15 秒の高品質音声/歌声同期動画生成

- LTX Video モデル

-

- LTX Video 13B: 長尺動画用、720p 高速生成、VRAM 要件 4 倍削減

- LTX Video 13B Distilled: 1 分以内で生成、高速かつ高品質

モデルを理解したら次はUIの解説をします。

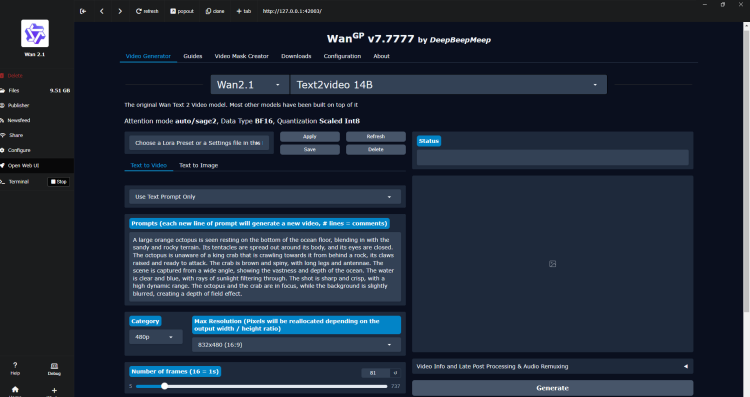

Wan2.1の管理画面の解説

- モデルの選択項目

- プロンプト入力欄

- 画質と動画比率の切り替え

- 詳細設定機能

- 生成開始ボタン

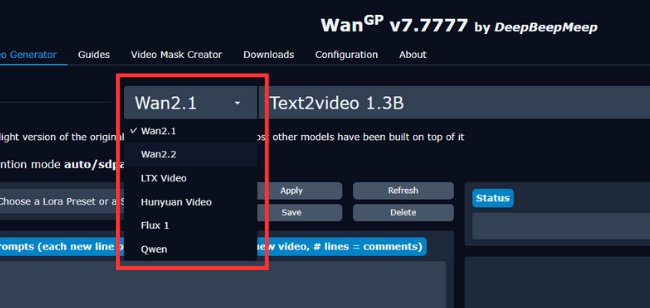

①モデルの選択項目の解説

Wanのバージョンや動画生成モデルの切り替えを行えます。最新はWan2.2になります。

モデルの解説にも書きましたが、テキストから動画を生成するモデルや画像から動画を生成するモデルなどいろいろあり、どんな動画を生成したいのかを選びます。

またモデルバージョンによって選べるモデル数に違いがあります。

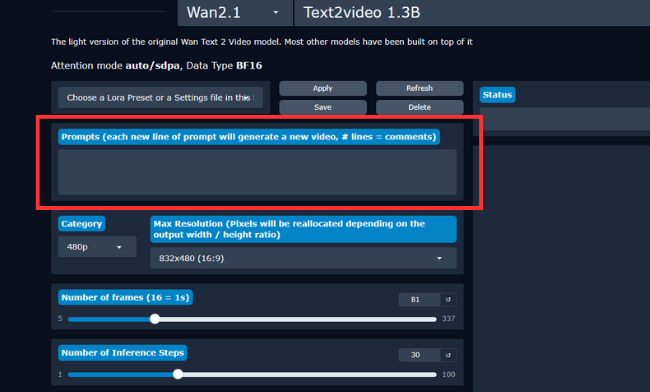

②プロンプト入力欄

Wan2.1では日本語でプロンプトに対応しておりSoraAIのように気楽に動画生成ができます。

しかし日本独特の表現などはほかのAIソフト同様に理解できないのでより厳密に生成をするなら翻訳サイトを利用して英語プロンプトで生成するのが良いです。

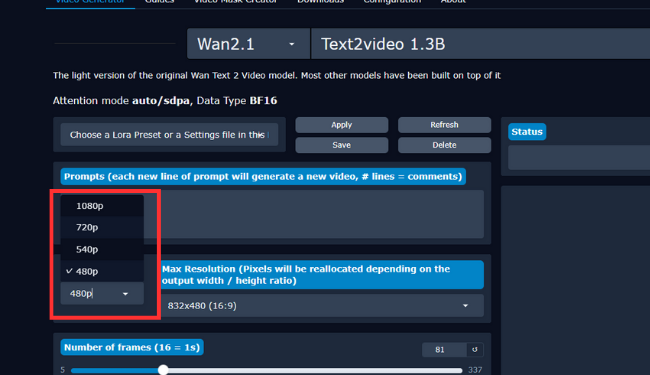

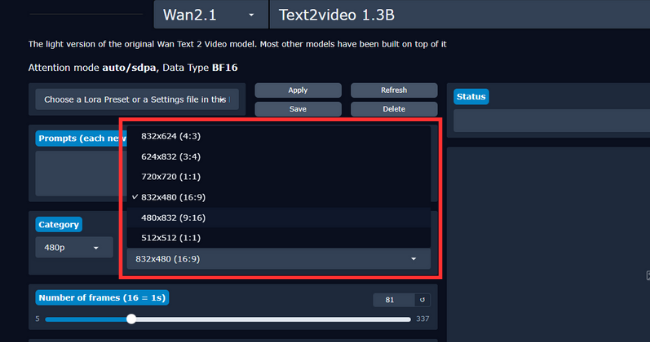

③画質と動画比率の切り替え

動画の画質を選択できます。最高で1080pまで生成できます。

動画比率として正方形からスマホサイズまで選択できます。

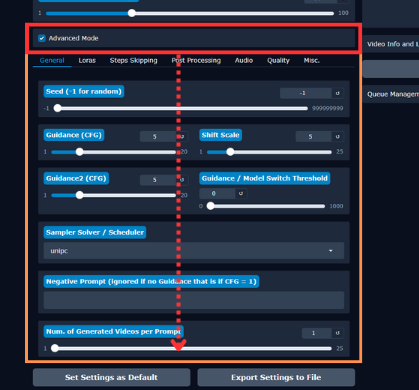

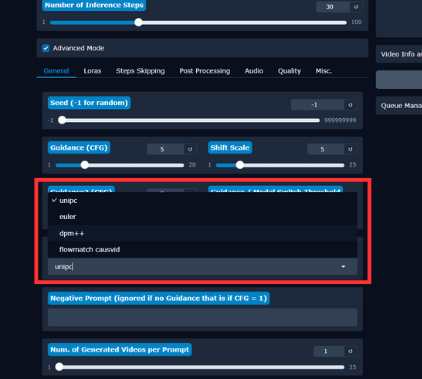

④詳細設定機能

アドバンスモードという項目にチェックを入れると詳細な設定をできるエリアが表示されます。

動画のサンプラーも選択できる項目があります。

Loraやネガティブプロンプトを入力する箇所や音楽を入れることもできます。

次は実際にプロンプトを入力して動画を生成してみます。

プロンプト:リアルテイスト、アロハシャツに麦わら帽子を被ったゴールデンハムスターがビーチで日光浴をしている。

Realistic taste, a golden hamster wearing an aloha shirt and a straw hat is sunbathing on the beach.生成した動画がこちら

今度は人間を生成してみることにしました。

プロンプト:アジア人女性二人、オフィスカジュアルな服装で笑いながら会話している。

Two Asian women dressed in office casual attire are laughing and talking.生成時間: 9m 58s

動きを加えると破綻が見えた、特に手や指がおかしいのであたりのSEED値をさがすかネガティブプロンプトをしっかり入力する必要がありそう。

ComfyUIでのワークフロー構築方法

*現在動作をテスト中、後日追記予定

ComfyUIを利用すれば、直感的にカスタマイズができワークフローを詳細に組み立てられるようです。

- モジュールをドラッグ&ドロップ

- ノード同士を接続して処理を可視化

- 条件分岐やループを設定可能

可視的なフロー設計により、複雑なプロセスも理解しやすくなります。

wan2.1をローカルでの使い方をさらに便利にする方法

- LoRA対応による拡張と活用

- 料金プランと利用可能な範囲

- ライセンスに関する注意点

- ディスコードを通じたサポートの活用

- Discordチャンネルから利用する方法

- GoogleColabで利用する方法の選択肢

- wan2.1 ローカル 使い方のまとめ

LoRA対応による拡張と活用

- Lorasを使えば「スタイル追加」「キャラクター再現」「動画高速化」が可能

- Multiplier と プリセット を活用すれば柔軟かつ効率的

- Accelerator Lora を組み合わせることで大幅に時間短縮できる

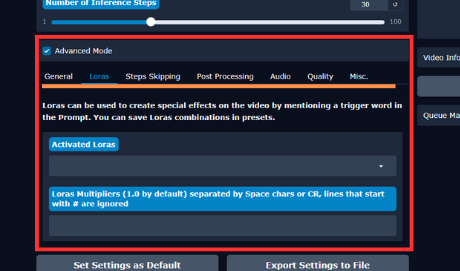

Wan2.1ではLoRAをLorasと呼称しており、機能も同じようになっています。以後Lorasと呼びます。

動画生成をもっと自分好みにカスタマイズしたい!

そんなときに役立つのが Loras(Low-Rank Adaptations) です。

Loras を使えば、WanGP のモデルに「特定のスタイル」「キャラクター」「効果」を簡単に追加できます。導入方法から使い方・応用テクニックまでをわかりやすく解説します。

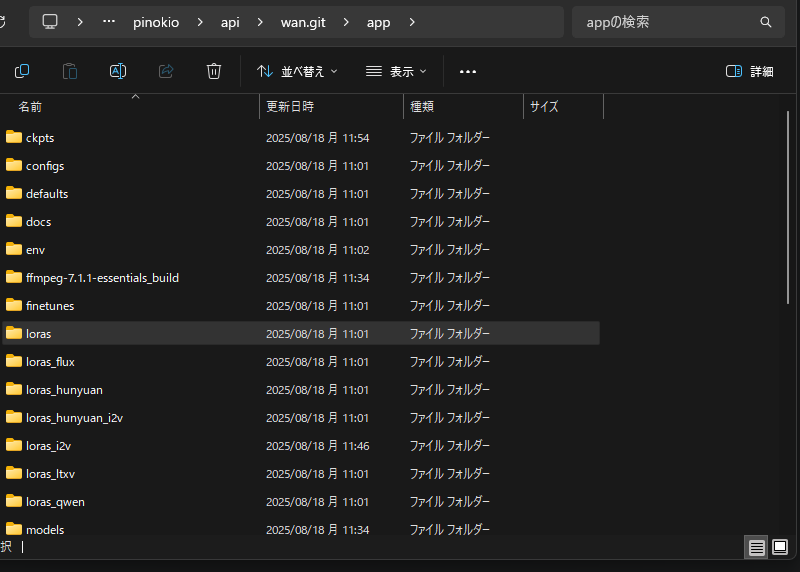

Lorasの基本とディレクトリ構造

Loraファイルは、対象モデルごとにフォルダに配置します。

- Text-to-Video (T2V) →

loras/,loras/1.3B/,loras/14B/ - Image-to-Video (I2V) →

loras_i2v/ - Hunyuan モデル →

loras_hunyuan/,loras_hunyuan_i2v/ - LTX Video →

loras_ltxv/ - Flux →

loras_flux/

Loras の使い方

- Loraファイルをフォルダに配置

- WanGPを起動

- Advanced → Loras セクションを開く

- 使いたいLoraにチェック

- Multiplier(倍率) を設定(初期値は 1.0)

⑤Multiplierの設定方法について

倍率は「どのくらいLoraを効かせるか」を決めるものです。いろいろな設定方法があります。

- 単純な倍率

1.2 0.8→ Lora1: 強め、Lora2: 弱め - 時間ベース(ステップごとに変化)

0.9,0.8,0.7→ 生成の進行に合わせて効果が変化 - Wan 2.2 特有(High Noise / Low Noise フェーズ分け)

0;1→ High Noise 無効、Low Noise 有効

Loraプリセットで手軽に再利用

同じテイストで動画を生成する人には毎回数値を設定するのが面倒だと思います。

そこで便利なのが プリセット機能。このファイルを作っておけば毎回の起動時の設定を効率よく、または昔作ったテイストを試したいときにもすぐに反映できて楽です。

- Lora+倍率+プロンプトを

.lsetファイルとして保存 - 起動時に読み込み可能

- Web UI から編集・削除・共有もOK

Loras Accelerators – 高速化の秘密

一部のLoraは 生成を高速化 するために設計されています。

代表的なものは以下の通り

| 名前 | 特徴 | 生成ステップ |

|---|---|---|

| FusioniX | 複数加速器+スタイル統合、品質も向上 | 8–10 |

| Safe-Forcing lightx2v | 2ステップ生成可、2倍速 | 2–8 |

| CausVid | 4–12ステップ生成、2倍速 | 12(推奨) |

| AccVid | cfg=1で動作、通常より高速 | 通常と同じ |

特によさげな生成結果を探すために大量生成したい場合に「CausVid Lora」がよく選ばれています。

その他パフォーマンス向上のコツ

- アプリ再起動なしで追加/削除可能

--check-lorasで非互換ファイルをフィルタ- Loraはオンデマンドで読み込み → VRAM節約

- 複数同時使用もOK

- 探すなら Civitai / HuggingFace / Discord

- 作成するなら Kohya / OneTrainer / 自作データセット

よくあるトラブル

- Loraが効かない → モデルサイズ(1.3B / 14B)や形式を確認

- 処理が重い → 有効Loraを減らす / 倍率を下げる

- メモリエラー → 小さいモデルを選ぶ / 解像度を下げる / 量子化を有効化

WanGP を使いこなすなら、Loras の理解は必須!

ぜひ試して、あなたの作品に個性とスピードを加えてください。

料金プランと利用可能な範囲

wan2.1自体はオープンソースで提供されているため無料です。

ライセンスに関する注意点

商用利用の可否や配布制限は、利用規約に従う必要があります。特に商用で利用する場合には、必ずライセンス条項を確認することが欠かせません。

Discordチャンネルから利用する方法

一部の機能はDiscordチャンネル経由で利用可能です。環境構築が難しい人にとっては手軽な選択肢になりますが個人で運営されているチャンネルしか見当たらなかったのでここに掲載はしません。ご自身で見つけた場合も注意して参加してください(クレジット制で料金を請求される可能性がある)。

Wanの運営に直接問い合わせたい場合は運営のディスコードにメッセージを送ってください。

https://discord.com/invite/AKNgpMK4Yj

GoogleColabで利用する方法の選択肢

GoogleColabを活用することで、ローカル環境が整っていなくても利用できます。ただし、Colab環境の制約があるため、処理速度や保存領域に注意が必要です。

この記事ではローカル環境構築について記述しているためColab環境に関しては言及しません。

wan2.1 ローカル 使い方のまとめ

- Wan2.1の基本機能を理解することが鍵

- 高速処理や柔軟なカスタマイズが魅力

- 動作環境を満たして安定稼働を実現

- RTX5000シリーズ特有のエラー対策

- ComfyUIで直感的なワークフロー構築が可能

- LoRAで表現力をさらに拡張できる

- ライセンス確認で商用利用のリスクを回避

- Discordコミュニティを活用して疑問を解決

- Discordチャンネル経由で環境構築不要の利用も可能

- GoogleColabで手軽に始められる選択肢がある

- wan2.1 ローカル 使い方を理解すれば効率的な作業が可能

- 自分に合った利用方法を見極めてモデル選択をして生成時間を節約する

- 継続的なアップデートでさらに快適な利用が期待できる

情報をもっと得たい方向けにコミュニティの様子や作例などがRedditで確認できます。

https://www.reddit.com/r/comfyui/comments/1jno096/wan_released_videotovideo_control_loras_some